انتخابات دیپفیک

ریشی آیینگار | خبرنگار فارین پالیسی در حوزه ژئوپلیتیک و سردبیر اسبق سیانانبیزینس

ترجمه: فاطمه لطفی

هفتهنامه صدا

پیش از اینکه آخرین انتخابات ملی هند در سال 2019 برگزار شود، در توییتر شایعهای پخش شد که میگفت جوهر پاکنشدنی که مقامات انتخاباتی هند با آن ناخنهای رایدهندگان را برچسبگذاری میکند حاوی خون خوک است.

یوئل راث، رئیس وقت یکپارچگی انتخاباتی این پلت فرم رسانه اجتماعی، در مصاحبهای یادآور شد: « در درجه اول این تاکتیک انتشار اطلاعات غلط بود با هدف سلب حق رای مسلمانان و منصرف کردن آنها از رای دادن؛ درحالی که این شایعه واقعیت نداشت. بنابراین توییتر سیاستهای خود را به گونهای تنظیم کرد که بیان کند که پیشبرد آن نوع روایت نادرستِ سرکوب رایدهندگان، نقض قوانین سایت است و از این رو پستها حذف میشوند و کاربران تحریم.»

راث حالا از این موضوع نگران است که اگر چنین اتفاقی امروزه رخ دد، پاسخی که [از گردانندگان] این پلتفرم خواهیم شنیید کاملا متفاوت باشد یا بدتر از آن، اصلا پاسخی وجود نداشته باشد.

«توئیتر» دیگر واقعا وجود ندارد. این پلتفرم اکنون X نامیده میشود که توسط میلیاردر آمریکایی، ایلان ماسک، و پس از پرداخت 44 میلیارد دلار در سال 2022، خریداری و نام آن تغییر یافت. ماسک بلافاصله نیمی از کارکنان شرکت، از جمله اکثر تیمهای اعتماد و ایمنی را که تحت رهبری راث بودند و محتوای گمراه کننده و مضر را حذف میکردند، اخراج کرد. خارج از این سکوی نرمافزاری، خود راث در نوامبر 2022، کمتر از یک ماه پس از روی کار آمدن ماسک، از توییتر استعفا داد. سیاست ماسک برای آزادی بیان بیقید و شرط، همراه با بازنگری در سیستم راستیآزمایی که قبلا به کاربران کمک میکرد حسابهای معتبر را شناسایی کنند، منجر به پخش سیل اطلاعات نادرست و سخنان نفرتانگیز در این پلتفرم شده است. (خود راث با بسیاری از آن مواجه شده است.)

درخواستهای بسیاری از تیم مطبوعاتی X ثبت شده که میخواهند در مورد چگونگی آمادهسازی این پلتفرم برای انتخابات در سال 2024 توضحاتی ارائه دهد اما پاسخی خودکار برای این درخواستها ارسال شده است: «[پلتفرم] اکنون مشغول است، لطفا بعدا بررسی کنید». البته خود این دو جمله هم نسبت به پاسخی که کاربران پیشتر دریافت میکردند بهبود مختصری یافته است؛ پیشتر در پاسخ به این سوال صرفا یک ایموجی نمایش داده میشد.

X تنها پلتفرم اصلی رسانه اجتماعی نیست که تعداد ناظران محتوای آن بسیار کم است. متا که مالک فیسبوک، اینستاگرام و واتساپ است، از نوامبر 2022 بیش از 20000 کارمند را اخراج کرده است؛ که تعدادی از این کارمندان برای بخش اعتماد و ایمنی کار میکردند؛ و از سویی بسیاری از کارمندان یوتیوب که روی سیاستهای اطلاعات نادرست کار میکردند تحت تاثیر اخراج کارکنان شرکت مادر گوگل قرار گرفتند.

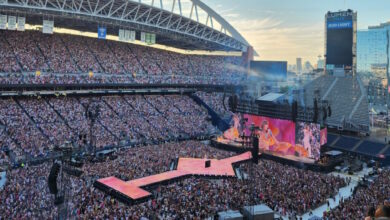

به ندرت میتوان تصور کرد [که سالی بدتر از سال 2024] هم برای مبارزه با محتوای مضر آنلاین در شبکههای اجتماعی وجود داشته باشد. امسال در بیش از 50 کشور جهان از جمله سه دموکراسی بزرگ جهان و نیز تایوان، که یک نقطه داغ ژئوپلیتیکی است که به طور فزایندهای مخاطرهآمیز هم شده است، انتخابات ملی برگزار میکنند. هفت کشور از 10 کشور پرجمعیت جهان یعنی بنگلادش، هند، اندونزی، مکزیک، پاکستان روسیه و ایالات متحده به طور جمعی یک سوم جمعیت جهان را پای صندوقهای رای خواهند فرستاد.

انتخابات، با پویاییهای هیجانی و اغلب قبیلهایاش، همان نقطهایی است که گامهای نادرست برداشتن اطلاعات نادرست را راهی وطن میکنند. اگر اطلاعات نادرست رسانههای اجتماعی را معادل فریاد «آتش» در یک سالن شلوغ در نظر بگیریم، اطلاعات غلط انتخاباتی به مثابه آن است که فریاد «آتش» در زمانی طنینانداز شود که یک فیلم ترسناک در همان سالن پخش میشود و همه مردم از پیش هم عصبی و تحریک شده بودهاند.

کیتی هاربث [مشاور سیاستمداران و دولتها برای استفاده از رسانههای اجتماعی] قیاس متفاوتی را ترجیح میدهد، قیاسی که نشان میدهد مسائل تا چه حد مبهم و مشکلزا هستند و عدم اطمینان محض پیرامون آنها بسیار بالاست. او در مصاحبهای در ماه اکتبر گفت: «استعارهای که من همیشه از آن استفاده میکنم کالیدوسکوپ [زیبابین] است، زیرا جنبههای مختلفی در این مورد وجود دارد، اما بسته به اینکه چگونه کالیدوسکوپ را بچرخانید، الگوی شکل ظاهری آن تغییر می کند. و این همان احساسی است که من در مورد زندگی پس از 2024 دارم. … نمیدانم کجای کالیدوسکوپ قرار است فرود بیاید.»

کار هاربث به نوعی مربیگری در صنعت تکنولوژی است و از سال 2011 یک دهه را در فیسبوک گذرانده است و در جهت تلاش برای [آموزش] یکپارچگی انتخاباتی این شرکت را پایهگذاری کرده است. او در سال 2021 شرکت Anchor Change را تأسیس کرد، که یک شرکت مشاوره سیاست عمومی است که به دیگر پلتفرمها در مبارزه با اطلاعات نادرست کمک کرده و آمادگی آنها را برای انتخابات بیشتر میکند.

هاربث میگوید که اگر او در شغل قبلی خود بود، تیم او ارزیابی خطرات انتخابات جهانی را تا اواخر سال 2022 یا اوایل سال 2023 تکمیل میکرد و بعد بقیه سال را صرف این میکرد محصولات متا را برای آنها طراحی کند و نیز هر جایی که لازم بود «اتاقهای جنگ» انتخاباتی راهاندازی کند. او میگوید «در حال حاضر ما حرکت به سمت حالت اجرا را شورع خواهیم کرد.» هاربث هشدار میدهد که به منابعی که شرکتها برای یکپارچگی انتخابات به کار میبرند به چشم بازی اعداد نگاه نکنیم «وقتی برخی از آن ابزارها را ایجاد میکنید، نگهداری از آنها به افراد زیادی نیاز ندارد» اما اذعان میکند که تخصیص منابع نشان دهنده اولویتهای رهبری شرکت است.

این شرکتها اصرار دارند که به یکپارچگی انتخابات متعهد میمانند. آیوی چوی، سخنگوی یوتیوب در بیانیهای گفت: «یوتیوب به شدت روی سیاستها و سیستمهایی سرمایهگذاری کرده است که به ما کمک میکنند با موفقیت از انتخابات در سراسر جهان حمایت کنیم.» تیکتاک گفته در مجموع 40هزار متخصص ایمنی دارد و با 16 سازمان حقیقتسنج با 50 زبان جهانی همکاری میکند. متا از اظهار نظر در مورد این موضوع خودداری کرد، اما یکی از نمایندگان شرکت فارن پالیسی را به پست وبلاگ اخیر نیک کلگ، معاون سابق نخست وزیر بریتانیا، ارجاع داده که اکنون به عنوان رئیس امور جهانی متا شناخته میشود. کلگ در این پست نوشته: ما حدود 40 هزار نفر را داریم که در زمینه ایمنی و امنیت کار میکنند، و از سال 2016 بیش از 20 میلیارد دلار سرمایه گذاری در تیمها و فناوریهایی انجام دادهایم که در این زمینه متخصص هستند.

اما علائم نگران کننده دیگری نیز وجود دارد. یوتیوب ژوئن گذشته اعلام کرد که حذف محتواهایی را که ادعاهای نادرست در مورد انتخابات ۲۰۲۰ ایالات متحده یا انتخابات گذشته منتشر میکنند متوقف میکند و متا بیسر و صدا سیاست مشابهی را در قوانین تبلیغات سیاسی خود در سال ۲۰۲۲ در پیش گرفت. و همانطور که سوابق پیشین نشان داده است، این پلتفرمها تمایل دارند پوشش کمتری در خارج از غرب داشته باشند، درحالی که با نقاط کور بزرگی که در زمینه زبانها و بسترهای محلی دارند، پخش اطلاعات نادرست و سخنان نفرتانگیز نه تنها فراگیرتر، بلکه خطرناکتر نیز میشوند.

نیت داد، مدافع پاکستانی حقوق دیجیتال که در هیئت نظارت متا نیز عضویت دارد، در مورد تصمیمات تعدیل محتوا میگوید: «افرادی که روی حقوق دیجیتال در این منطقه کار میکنند، مدتهای طولانیست که این موضوع را مطرح کردهاند. به نحوی که این شرکتها به انتخابات در دموکراسیهای غربی اهمیت میدهند، [اما درباره دیگر نقاط دنیا] چنین توجهی جلب نمیشود.»

نیت داد میگوید «اینطور نیست که آنها کاری انجام نمیدهند… فکر میکنم این شرکتها به اندازه کافی تلاش نمیکنند» و او در این احساس تنها نیست: راث نیز پیشبینی بدی دارد.

او میگوید: «من فکر میکنم چشمانداز تهدیدات پیش روی پلتفرمهای رسانههای اجتماعی و رأیدهندگانی که از آنها استفاده میکنند چندان تغییر نکرده است، اما سطح آمادگی در پلتفرمهای رسانههای اجتماعی بزرگ تغییر کرده است. در سطوح بالا، من نگران این هستم که پلتفرمهای بزرگ در برابر تهدیدات امنیتی انتخاباتی در سال 2024 نسبت به هر چرخه اصلی انتخابات جهانی از سال 2016 آمادگی کمتری داشته باشند.»

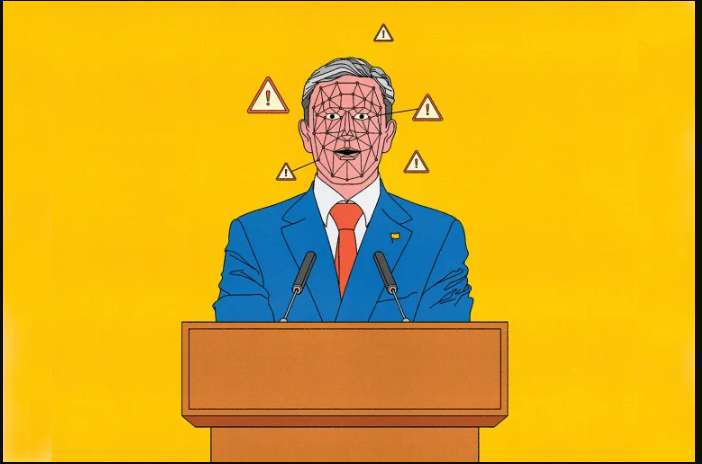

و این همه حتی بدون اشاره به هوش مصنوعی است. این فناوری سالها است که به اشکال مختلف وجود داشته است، اما در ماه نوامبر 2022، زمانی که اوپنایآی مستقر در کالیفرنیا چتجیپیتی را راهاندازی کرد، به نقطه عطفی رسید. چت بات و ارتقاهای بعدی آن، که قادر به تولید نوشتهجات متنی دستوری در عرض چند ثانیه بود، چرخه تبلیغات فناوری را برای اعصار [آینده] آغاز و تلاشها برای برتری در بین شرکتها در سراسر جهان را بیشتر کرد. متا، گوگل و مایکروسافت (که میلیاردها دلار هم در اوپنایآی سرمایه گذاری کرده است) چت رباتهای خود را راهاندازی کردند، شرکتهای جدیدتر هوشمصنوعی مانند آنتیتروپیک، اینفلکشن و Cohere و شرکتهای بزرگ فناوری چینی بایدو، تنسنت و علیبابا هم از این قافله عقب نماندند.

البته تولیدات آنها فقط متن نیست. اوپن ایآی همچنین مالک DALL-E است، یکی از بسیاری از تولیدکنندگان تصویری هوش مصنوعی موجود در بازار، و درنتیجه تنظیم صدا و تصویر را بر اساس نیازهای فرد با به اصطلاح ابزارهای هوش مصنوعی بینهایت آسان شده است. این ابزارها به این دلیل که توانایی آنها در تولید طیف گستردهای از محتوای آنلاین در رسانههای مختلف در پاسخ به درخواستهای کاربر بالاست، متأسفانه این پتانسیل را دارند که اطلاعات نادرست رسانههای اجتماعی را به گونهای افزایش دهند که قبلا چنین سابقهای دیده نشده است.

رامن چاودری، یکی از همکاران مسئول دانشگاه هاروارد در مرکز اینترنت و جامعه برکمن کلاین دانشگاه هاروارد و یکی از بنیانگذاران شرکت غیرانتفاعی ایمنی هوش مصنوعی، هیومن ایتلیجنت، میگوید: «تولید و انتشار دیپفیکهای بسیار واقعی و واقعیتهای به ظاهر دیپفیکهای بسیار بسیار آسانتر میشود. چاودری نسبت به بسیاری از افراد دیدگاه آگاهانهتری در مورد نقطه تقاطع هوش مصنوعی، اطلاعات نادرست و رسانههای اجتماعی دارد و قبلا تیم اخلاقی هوش مصنوعی توییتر را رهبری میکرد و یکی دیگر از قربانیان حمله ماسک به نیروی کار ایمنی شرکت بوده است. او از زمان خروج اجباری خود در ماه نوامبر 2022، مدت زمانی را صرف سازماندهی تمرینات «تیم قرمز» کرده است، از جمله آنها تمریناتی ست که کاخ سفید هم از آنها حمایت کرده است، در این تمرینات شرکت کنندگان سعی میکنند محدودیتهای مدلهای هوش مصنوعی را افزایش دهند تا ببینند در یک محیط کنترل شده چه آسیبهایی میتوانند ایجاد کنند. چاودری با اشاره به تحقیقات اخیر خود با یونسکو در مورد خشونت مبتنی بر جنسیت در بستر هوش مصنوعی و تمرین گروهی قرمز با دانشمندان آب و هوا، گفت که پیامدهای انتشار ممکن است به خصوص نگران کننده باشد. مدلهای Al Generative میتوانند به بازیگران بد کمک کنند تا اطلاعات نادرست را برای مخاطبانی ارسال کنند که به احتمال زیاد با آن پیام تغییر نظر میدهند: برای مثال، مادران کودکان خردسال، یا افرادی که به دلایل خاصی دلسوزی بسیار دارند. بعد میتوانند کمپینهایی طراحی کنند که نهتنها استراتژی میدهند که چه پستهایی را برای چه کسی ارسال کنند، بلکه کدی را نیز بنویسند تا برای آنها ارسال شود.

چاودری میگوید «و باز هم، همه اینها کاملا قابل انجام است. ما به معنای واقعی کلمه این کار را انجام دادهایم، این کار را برای تکمیل این گزارش انجام دادیم.»

شرکتها و دولتها در تلاش برای نصب تجهیزات محافظتی هستند. متا، تیک تاک، مایکروسافت و یوتیوب همگی برخی از الزامات را بر سازندگان و تبلیغکنندگان سیاسی تحمیل کردهاند تا زمانی که محتوایشان با استفاده از هوش مصنوعی ایجاد شده است، حتما آن را اعلام کنند. ابتکارات دولتی و چندجانبه برای تعیین چارچوبهای نظارتی در مورد فناوری در دستور اجرایی اخیر دولت بایدن در مورد هوش مصنوعی گنجانده شده است. اجلاس ایمنی هوش مصنوعی که نوامبر گذشته در بریتانیا برگزار شد؛ هیئت مشورتی جدید هوش مصنوعی در سازمان ملل؛ و قانون اتحادیه اروپا که انتظار میرود تا سال 2025 لازم الاجرا شود.

آلوندرا نلسون، یکی از بازیگران کلیدی در حداقل سه مورد از این ابتکارات، نسبت به این تلاشها خوشبینی محتاطانهای دارد. نلسون بهعنوان مدیر سابق دفتر سیاستگذاری علوم و فناوری کاخ سفید و دستیار معاون جو بایدن، «طرح 2022» دولت بایدن برای منشور حقوق هوش مصنوعی را رهبری کرده و چند روز پس از شرکت در اجلاس بریتانیا و انتصاب به عنوان هیئت مشورتی سازمان ملل، در این اجلاس سخنرانی داشت. او گفت: «در میان بسیاری از سیاستگذاران جهانی در مورد فقدان اقدامات نظارتی پیرامون هوش مصنوعی، یک احساس ناامیدی به وجود آمده. اما به نظر میرسد که سد شکسته شده، اما هنوز در مراحل اولیه است».

سوال مطرح نه تنها در میان سیاستگذاران، بلکه در میان مدیران صنایع و جامعه مدنی این است که آیا میتوان آن نردههای محافظ را به اندازه کافی سریع در [پلتفرمهای انتشار دهنده اطلاعات غلط] قرار داد، آن هم در صورتی که همه توافق کنند که [قرار است از چه چیز] در برابر چه چیزی محافظت کنند؟

اوپنایآی در خط مقدم هشدارهایی بوده است که نشان میدادند ابزارهای این سیستم چقدر مضر هستند و در عین حال به توربوشارژ کردن قابلیتهای آن ابزارها ادامه میدهد. در ژوئیه 2023، این شرکت شراکتی به نام فروم مدل فرونتایر با آنتروپیک، گوگل و مایکروسافت تشکیل داد تا با یکدیگر در زمینه ایمنی هوش مصنوعی همکاری کنند، و سام آلتمنِ اوپنایآی، رهبر قدیمی این حوزه و سردسته آنها در راس این فراخوان برای تنظیم مقررات دولتی صنایع اوپنایآی بود.

آلتمن تنها چند روز پس از میزبانی اولین کنفرانس توسعه دهندگان اوپنایآی، که در آن این شرکت از چت ربات جدید خود و همچنین توانایی ایجاد جیپیتیهای سفارشی برای اهداف خاص رونمایی کرد، در اجلاس مدیران عامل شرکتهای همکاری اقتصادی آسیا و اقیانوسیه در سانفرانسیسکو هشدار شدیدی در مورد هوش مصنوعی و انتخابات مننتشر کرد. او در 16 نوامبر در سخنرانی در یک پانل گفت: «مسئله خطرناک آن چیزی نیست که ما قبلا درک کردهایم. بلکه همه آن چیزهای جدید است، مجهولات شناخته شده، مجهولات ناشناخته. مسائل بسیاری است که ما نمیدانیم، زیرا همه چیز را که ندیدهایم، نمیدانیم چه ویدئوی مولدی یا هر چیز دیگری چه کاری میتواند انجام دهد، و این در طول سال انتخاباتی پیش رو، بسیار سریع و خشمگین به سمت ما خواهد آمد».

در ماه سپتامبر اوپنایآی شاید برای اینکه سوء استفاده احتمالی از آن را تشخیص دهد بکی ویت، یکی از مدیران سابق متا را به عنوان رئیس انتخابات جهانی خود منصوب کرد. با این حال، مأموریت ویت و استراتژی انتخابات اوپنایآی هوز هم نامشخص است. (وایت به چند بار درخواست ما برای اظهار نظر پاسخ نداد و اوپنایآی برای او یا هر مدیر اجرایی دیگری درباره پاسخ به این سوالات ممنوعیت قائل شده است.)

کمتر از یک روز پس از هشدار انتخاباتی آلتمن در آن سخنرانی، اوپنایآی در نوعی هرج و مرج فرو رفت، هرجومرجی که همه نگران بودند نکند حاصلش راه بر دموکراسی پیدا کند. در 17 نوامبر، هیئت مدیره شرکت اعلام کرد که آلتمن اخراج شده است، و بلافاصله این حکم اجرایی شد، زیرا «او به طور مداوم در ارتباطات خود با هیئت مدیره صادق نبود.» گرگ براکمن، رئیس اوپنایآی، اندکی پس از آن در اعتراض به این اخراج استعفا داد و ظاهرا برکناری این دو، شورش گستردهای را در میان کارمندان شرکت ایجاد کرد. آلتمن و براکمن پنج روز بعد با هیئت مدیره جدید و دو مدیر عامل موقت به اوپنایآی بازگشتند و در حال حاضر یکی از آشفتهترین چرخههای خبری سیلیکون ولی در سالهای اخیر را در بستر خود پرورش دادند.

تحولات اوپنایآی شاید یادآور حقیقت ناخوشایند دیگری بود: هر چه فناوری تاثیرگذارتر باشد، به همان اندازه هوش مصنوعی، خوب یا بد، تا حد زیادی به هوسهای هیئت مدیره شرکتها یا میلیاردرهای عجیب و غریب بستگی دارد. نلسون میگوید: «عدم تقارن اطلاعاتی در مورد مدلهای هوش مصنوعی، دادههای هوش مصنوعی که شرکتها در اختیار دارند، وجود دارد و بنابراین حتی اگر دولتها نمیخواهند با شرکتها شراکت داشته باشند، حداقل باید با بازیگران بزرگ صنعت همکاری کنند. از سوی دیگر، مشارکت از نظر طراحی باید تا حدودی خصمانه باشد، به ویژه در لحظهای که محصولات بدون مراقبتهایی در دسترس عموم قرار میگیرند که فکر میکنم بسیاری موافق هستند که باید چنین باشد.»

در حالی که به نظر میرسد اقدامات دولت در مورد هوش مصنوعی تا حدودی سریعتر از فناوریهای قبلی پیش میرود، میلیاردرهایی که این نمایش را اداره میکنند هنوز هم قدرت نامتناسبی دارند.

چاودری میگوید «ما قطعا شاهد بودهایم که دولتها سعی میکنند مخالفان را با استفاده از قوانینی خفه کنند که این قوانین خود قرار است از ما در برابر افراط گرایی آنلاین محافظت کند، بنابراین این سوال پیش میآید که داور حقیقت کیست؟ چه کسانی قادرند تصمیم بگیرند که چه چیز درست است و چه چیز درست نیست؟ و در حال حاضر، همین اشخاص هستند که شرکتهای رسانههای اجتماعی را اداره میکنند».

برای کسانی که میخواهند طرفداران شیطان برای رستاخیز هوش مصنوعی باشند، سه استدلال تا حدی قانعکننده وجود دارد.

اولین مورد، نقش هوش مصنوعی در ارائه راه حل بالقوه است. شرکتهای رسانههای اجتماعی بیشتر به ابزارهای تشخیص خودکار به عنوان یک سیستم هشدار زودهنگام متکی هستند تا بتوانند فیلتری برای اطلاعات نادرست و سخنان مشوق عداوت و تنفر باشند و میزان محتوایی را که بازبینهای انسانی باید به آن نگاه کنند را تعین نمایند. بر اساس گزارش شفافیت یوتیوب از آوریل تا ژوئن 2023، این ابزارها 93 درصد از ویدیوهایی را شناسایی کردند که در نهایت به دلیل نقض خطمشیهای پلتفرم حذف شدند. در تیکتاک، این عدد حدود 62 درصد بود. متا از سال 2020 استفاده از ابزارهای هوش مصنوعی را برای تعدیل محتوا افزایش داده است و همچنین میگوید فناوری آن بیش از 90 درصد از محتواییهایی را که شرایط و خطمشیهای متا را نقض میکنند، قبل از گزارش کاربران تشخیص میدهد. کریس کاکس، مدیر ارشد تولید متا گفت: «هوشمصنوعی هم شمشیر است هم سپر».

اما تکیه بیش از حد به هوش مصنوعی نیز خطر قابلتوجهی دارد، خواه به صورت تصادفی گفتار مشروع را از بین ببرد یا بسترهای زبانی و محلی کلیدی را از دست بدهد. هاربث، گرداننده سابق بخش انتخابات فیسبوک، میگوید: «من فکر میکنم این نقطه همان جایی است که بسیاری از پلتفرمها بر این باورند که تعدیل محتوا به آنجا ختم میشود، یا حداقل امیدشان این است که هوش مصنوعی بتوانند با هوش مصنوعی مبارزه کنند. هیچ یک از طرفهای مبارزه با هوش مصنوعی در چنان سطحی از پیچیدگی قرار ندارند، اما شما فقط به آنها اجازه میدهید با آن مبارزه کنند.»

بحث دوم این است که اطلاعات نادرست تولید شده از سوی هوش مصنوعی ممکن است به شکلی که بازیگران بد قصد آن را داشته باشند، در مسیر دلخواه آنها قرار نگیرد. این تا حدی به این دلیل است که هشدارهای مکرر در مورد تصاویر اصلاحشده و ویدیوهای دیپفیک، کاربران رسانههای اجتماعی را بسیار بدبین و هوشیار کرده است (آنچه آلتمن از آن به عنوان «آنتیبادیهای اجتماعی» یاد میکند) و نیز به این دلیل که بسیاری از محتواها هنوز آنقدرها قانعکننده نیستند. تصاویر تولید شده توسط هوش مصنوعی اغلب با انگشتان یا اندامهای اضافی نشان داده میشوند و ویدیوهای دیپفیک هنوز هم نکات قابل توجهی دارند. راث، رئیس سابق اعتماد و ایمنی توییتر میگوید «ما هنوز سناریوی روز قیامت را که همه به آن فکر میکنند ندیدهایم، سناریوی که چنین تصور میشود: یک ویدیو پخش میشود، هیچکس نمیتواند درست یا نادرست بودن آن را بفهمد، بعد این ویدئو انتخابات را تغییر میدهد. [اما] مردم هنوز قادرند در برابر چنین چیزی واکنش نشان دهند و این نوع محتوا را رد کنند.» او اضافه کرد که جنبه نگرانکننده این است که به اشتباه ادعا میشود که ویدیوهای معتبر جعلی هستند و در نتیجه آب را بیشتر گلآلود میکنند، اما پلتفرمها باید سیستمهای مناسبی برای مقابله با محتوای گمراهکننده داشته باشند بدون اینکه به این نکته توجه کنند که این محتوی چگونه تولید میشود. راث میگوید «مهم نیست که هوش مصنوعی باشد یا نه، شما باید با محتوی گمراه کننده مقابله کنید».

این مسئله به استدلال سوم منتهی میشود: اینکه بازیگران بد در بسیاری از کشورها برای تأثیرگذاری به هوش مصنوعی نیازی ندارند. به عنوان مثال، هند را در نظر بگیرید، در این کشور پلتفرم پیامرسانی رمزگذاریشده واتساپ با بیش از نیم میلیارد کاربر، غالبترین پلتفرم مورد استفاده هندیهاست. به گفته محققان هندی و صحتسنجها، اطلاعات نادرستی که هم بهصورت خصوصی و هم به صورت عمومی به اشتراک گذاشته میشود و بسیاری از آنها توسط احزاب سیاسی و حامیان آنها تولید و نشر مییابد، هنوز هم تصاویری هستند که با عجله ویرایش شدهاند و در بستر مناسب خود نیستند. کیران گاریملا، استاد دانشگاه راتگرز که درباره اطلاعات نادرست آنلاین در جنوب جهانی تحقیق میکند، میگوید «شما میتوانید یک میلیون توییت تولید کنید، اما اگر فقط دو نفر آن را ببینند، چه کسی اهمیت میدهد؟ باور من این است که تفاوتی که هوش مصنوعی ایجاد میکند قابل توجه نخواهد بود زیرا مشروط به مکانیسمهای تحویل است.» به عبارت دیگر، اگر بازی فوروارد واتساپ شما به اندازه کافی قوی نباشد، مهم نیست که از هوش مصنوعی یا فتوشاپ استفاده کردهاید یا نه.

برای تامین کنندگان اطلاعات نادرست انگیزههایی وجود دارند تا خروجی خود را افزایش دهند. بر اساس آمارهای دولتی، در هند از زمان انتخابات 2019 تاکنون حدود 250 میلیون کاربر جدید اینترنت اضافه شده است. این افزایش با انفجار تلفنهای هوشمند ارزانتر و دادههای تلفن همراه ارزانتر امکانپذیر شد، اما این درحالی است که این اضافه شدنها بدون سواد دیجیتالی زیادی به وجود آمد که برای کاربرانی که برای اولین بار اینترنت داشتند لازم بود. سومیترا بدریناتان، استاد دانشگاه آمریکایی که درباره اطلاعات غلط سیاسی در هند مطالعه میکند، معتقد است: «یک موردی که ما درباره آن تحقیق کردهایم این بود که آیا شرکتهای فناوری برای سیل اطلاعات نادرست آماده هستند یا خیر. حتی اگر قالب تغییر نکرده باشد، سبک تغییر نکرده است. فقط مقدار خالص [دادههایی] که در آنجا وجود دارد، یا تعاملی که به دلیل تعداد کاربران بسیار زیاد آنلاین حاصل میشود، یکی از مواردی است که باید به آن توجه کرد.»

افشاگری مبنی بر دخالت روسیه در انتخابات ریاست جمهوری 2016 آمریکا، به ویژه از طریق فیسبوک، به یک میزان زنگ خطر بزرگی برای پلتفرمهای رسانههای اجتماعی و جامعه اطلاعاتی ایالات متحده بود و بُعد جدید نگران کنندهای به بحثها و چارچوببندی اطلاعات نادرست آنلاین و تاثیر بسیار آن و نحوه برخورد پلتفرمها به یکپارچگی انتخابات به وجود آورد. بر اساس گزارشی که از حالت اطلاعات ملی طبقه بندی شده خارج شده، تلاشهای روسیه برای اطلاع رسانی نادرست آنلاین در انتخابات 2020 ادامه یافته بود. دیگر یافته کلیدی آن گزارش چه بود؟ ما ارزیابی میکنیم که چین تلاشهای مداخلهای انجام نداده و تلاشهایی را برای تغییر نتیجه انتخابات در نظر گرفته، اما اعمال نفوذ نکرده است.

اما امسال چطور؟ و برای انتخابات ایالات متحده چطور؟ کاری نخواهد کرد؟ مقامات دولتی، کارشناسان امنیت سایبری و شرکتهای فناوری هشدار میدهند که تمایل چین برای انجام جنگ اطلاعاتی [علیه ایالات متحده] به طور عمده تغییر کرده است. مرکز تعامل جهانی وزارت امور خارجه در گزارشی در سپتامبر گذشته نوشت: چین به طور فزایندهای «تبلیغات، اطلاعات نادرست و سانسور» را در سراسر جهان به کار می گیرد و «سالانه میلیاردها دلار در جهت دستکاری اطلاعات خارجی هزینه میکند». تحلیلگرانِ تهدید در مایکروسافت به نتیجه مشابهی رسیدند: آنها در گزارشی در ماه نوامبر نوشتند که از آنجایی که حزب کمونیست چین «توانمندیهای تبلیغاتی و اطلاعات نادرست خود را افزایش داده است، این کشور برای نفوذ انتخاباتی در دیگر کشورها فعالتر شده است».

و در حالی که بیشتر نگاهها به نظرسنجیهای ایالات متحده در نوامبر امسال معطوف خواهد بود، یکی از اولین انتخابات سال میتواند نتیجه بخشترین [انتخابات برای اعمال نفوذ] باشد. تایوان قرار است رئیس جمهور جدید خود را در 13 ژانویه انتخاب کند، تصمیمی که قطعا پیامدهای ژئوپلیتیک گستردهای به دنبال خواهد داشت. در سال گذشته تنشها در اطراف این جزیره در بحبوحه سیاست خارجی تهاجمی فزاینده چین افزایش یافت، جزیرهای که پکن آن را به عنوان یک استان دور از سرزمین اصلی میداند که باید به این سرزمین بازگردد. چین فشار اقتصادی و نظامی بر تایوان را تشدید کرده است و این فشار احتمالا خود را در تلاش برای ایجاد تفرقه در میان رای دهندگان تایوانی نشان خواهد داد، در این جزیره تمایل سیاسی عمده آنها برای تعامل با چین است.

کمیسیون مرکزی انتخابات تایوان (CEC) در پاسخی کتبی به نشریه فارن پالیس در مورد بزرگترین چالشهایی که با آن مواجه است، نوشت: «بهویژه هر چه به روز انتخابات نزدیکتر میوشم، حجم اطلاعات نادرست به حد انفجار میرسد و در هر گوشهای نفوذ میکند. جستجوی فعال و بررسی اطلاعات نادرست، بار سنگینی بر دوش این کمیسیون است و حقایق و پاسخهای پاکشده ممکن است در حجم زیادی از اطلاعات نادرست کمرنگ شوند».

کمیسیون مرکزی انتخابات تایوان نقش خود را بیشتر به عنوان تلاشی مشترک، مشارکت با شرکتهای بزرگ رسانههای اجتماعی و تعامل با همتایان خود در کشورهای دیگر از طریق عضویت در انجمن سازمانهای جهانی انتخابات میداند. همچنین این کمیسیون میزبان هیئتهای آمریکایی، بریتانیایی و اروپایی هم بوده است.

یکی از ظرافتهای نجاتدهنده، جمعیت فوقالعاده آشنای تایوان با فنآوری اطلاعات است که سالها با فشار [تلاشهای منفی] آنلاین چین دست و پنجه نرم میکنند و و بسیار بیشتر از کمپینهای اطلاعات نادرست با هم هماهنگ هستند. سیل اطلاعات نادرست در جریان آخرین انتخابات جزیره تایوان در سال 2020، باعث شکست رئیس جمهور فعلی تسای اینگ ون نشد، رئیسجمهوری که حزب دموکراتیک ترقی خواه آن به مراتب کمتر از اپوزیسیون اصلی که برنده انتخابات مجدد کومینتانگ است، طرفدار چین است. لو ناچمن، استاد دانشگاه ملی چنگچی در تایپه میگوید « در واقع بسیاری از این کمپینهای اطلاعاتی [در تایوان] کارآمد نیستند، یا حداقل این کمپینها به شکلی کار نمیکنند که چین آنها را در نظر داشته باشد. حداقل خودآگاهی بیشتری نسبت به سالهای پیشین وجود دارد، بهویژه زمانی که در مورد چیزی مرتبط با چین بخواهیم نظر بگیریم.»

واشنگتن به دقت این مسائل را زیر نظر خواهد داشت. الیزابت آلن، معاون وزیر امور خارجه آمریکا در امور دیپلماسی عمومی و امور عمومی، در مصاحبهای میگوید: «آنچه میتوانم به شما بگویم این است که خود تایوانیها برخی از برجستهترین متخصصان را در مقابله با اطلاعات نادرست دارند، آنها مهمترین تواناییهای تحلیلی را دارند و در واقع ما در حال گفتوگو با آنها درباره فضای اطلاعاتی آنها هستیم. این به نفع ماست که یک انتخابات آزاد و عادلانه در تایوان برگزار شود.»

هاربث هم هشدار میدهد که استفاده چین از اطلاعات نادرست به عنوان یک ابزار ژئوپلیتیکی پیامدهای بالقوه گستردهای فراتر از تایوان یا ایالات متحده به دنبال خواهد داشت. او معتقد است «آنها به اندازه کافی برای تحریک مردم در ایالات متحده و اتحادیه اروپا تلاش خواهند کرد، اما تلاش واقعی آنها در آمریکای جنوبی و آفریقا خواهد بود.» در فضای پرتنش ژئوپلیتیک امروزی، با عمیق شدن شکاف بین دموکراسی و استبداد، خطر اطلاعات نادرست انتخاباتی هرگز بالاتر از این نبوده است. ایلین دوناهو، فرستاده ویژه وزارت امور خارجه و هماهنگ کننده آزادی دیجیتال، به فارن پالیسی گفت: «از بین رفتن اعتماد به یکپارچگی انتخابات، اعتماد به دموکراسی را از بین میبرد. ما در بحبوحه یک پدیده جهانی رو به رشد هستیم که در آن اعتماد و اطمینان به هر سه حوزه اطلاعات، انتخابات، و حکومتهای دموکراتیک در حال تضعیف است. این یک چالش ذاتی فرامرزی و جهانی است.»